SQLITE NOT INSTALLED

Последние насколько лет специализированные большие языковые модели (LLM — Large Language Models), работающие на основе нейросетей, представляют собой преобразующую технологию в здравоохранении с продемонстрированным воздействием на клиническую практику, медицинское образование и научные исследования. Статистика показывает значительный рост эффективности применения, что выражается, в основном в 70% сокращении административного времени для составления диагнозов, планов лечения и достижение профессионального уровня медицинских результатов на стандартизированных тестах. Например, ChatGPT предлагает персонализированные платформы обучения, автоматизированную оценку и мгновенный доступ к обширным медицинским знаниям в медицинском образовании, устраняя ограничения ресурсов и повышая эффективность обучения.

Он оптимизирует клинические рабочие процессы, поддерживая процессы сортировки, резюмируя важные уточнения в постановке диагнозов и облегчая административную нагрузку, позволяя медицинским работникам больше сосредоточиться на уходе за пациентами. Его способность обрабатывать и синтезировать огромные объёмы данных ускоряет исследовательские рабочие процессы, помогая в обзорах литературы, генерации гипотез и дизайнах клинических испытаний. Для пациентов предоставляет поддержку в персонализированных рекомендациях, напоминая о приёме лекарств, тем самым сокращая пробелы между клиническими визитами к врачу. Но многие практикующие специалисты, сталкиваясь с данной технологией, стали задаваться вопросом — а всё ли так безоблачно в данной сфере? Давайте попробуем разобраться.

Реализация полного потенциала искусственного интеллекта в здравоохранении требует устранения ключевых ограничений, таких, как отсутствие клинического опыта, неспособность обрабатывать визуальные данные и отсутствие эмоционального интеллекта. Этические, конфиденциальные и нормативные проблемы ещё больше усложняют его интеграцию. Будущие улучшения должны быть сосредоточены на повышении точности, разработке мультимодальных моделей ИИ, улучшении эмпатии с помощью анализа настроений и защите от ошибочных выводов. Эта неоднородность качества доказательств требует структурированного подхода к будущим исследованиям и внедрению, надёжных рандомных испытаний в медицинском образовании, предварительных наблюдательных исследований за эффективностью результатов в клинической практике.

В сфере искусственного интеллекта подмножество, известное как большие языковые модели, использует мощь глубокого обучения и обширных данных для понимания, обобщения, генерации и прогнозирования нового контента. Эти модели опираются на искусственные нейронные сети, обученные на обширных хранилищах информации текстовых данных, собранных не только из книг, документов, веб-сайтов и других источников, но и специализированных серверов, на которых расположены некоторые медицинские платформы. Благодаря быстрому обучению LLM приобретают способность генерировать связный и контекстно релевантный текст, различая закономерности и корреляции в своих обучающих данных. Эта компетентность в понимании и генерации языка значительно помогает таким приложениям, как машинный перевод и генерация текста.

Интеграция ChatGPT в системы здравоохранения представляет собой сложное взаимодействие между технологическими возможностями и системной готовностью. Недавние систематические обзоры показывают, что, хотя отдельные приложения показывают многообещающие результаты, системы здравоохранения сталкиваются со значительными проблемами при стандартизации и масштабировании его внедрения. Эти проблемы охватывают техническую инфраструктуру, интеграцию рабочих процессов, обучение персонала и политические рамки, что требует тщательного рассмотрения как прямых выгод, так и системных воздействий. Однако, насколько «искусственный разум» превосходит человека в сложных реальных сценариях, особенно в таких сложных областях, как медицина, остаётся открытым вопросом. Более того, этические проблемы всплывают при рассмотрении использования чат-ботов для написания научных статей, и уж тем более, при проведении важных медицинских испытаний новых методов лечения.

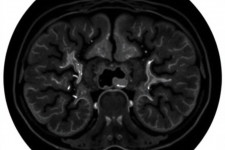

Подобные системы продемонстрировали исключительные возможности в медицинском образовании и предоставлении информации, достигнув высоких показателей сдачи экзаменов учениками, которые воспользовались их помощью. Исследования показывают особую силу в задачах клинического рассуждения с показателями точности 84% в вопросах на мышление низшего порядка — это может значительно способствовать упрощению понимания сложных заболеваний. Однако важно признать, что сдача экзамена не означает становление полностью компетентным медицинским специалистом. Например, в контексте нейрохирургического теста, специализированная обучающая модель ИИ столкнулась с трудностями при ответе на вопросы, основанные на изображениях или диаграммах, например, при определении конкретных анатомических структур. Это ограничение возникает из-за неспособности LLM обрабатывать визуальную информацию.

Аналогичным образом другие исследователи применили ChatGPT к экзамену по радиологии, подвергнув его комплексной оценке, включающей 150 вопросов с несколькими вариантами ответов, разработанных для соответствия стандартам экзаменов обычных выпускников. Эти вопросы были классифицированы на основе требуемых когнитивных навыков и охватывали физические и клинические аспекты. Система достигла общего уровня точности всего в 69%, что явно недостаточно для сдачи экзамена. Она нуждалась в помощи для точного решения вопросов, связанных с описанием точной диагностики болезни, изображений, вычислениями, классификацией и концептуальным применением. Зато продемонстрировала высокую производительность в вопросах клинического управления. Что касается конкретных тем радиологии, то эта модель столкнулся с большим количеством проблем даже с элементарными вопросами по физике — что для этой области медицины вовсе недопустимо.

В вопросах диагностики и оценки симптомов влияние на клиническую медицину остаётся несколько ограниченным, учитывая, что клиническая практика часто зависит от аналитики данных, клинических исследований, рекомендаций и производительности специализированных моделей ИИ. Как показывает практика, случайные ошибки или неточности всё ещё могут возникать. Поэтому консультации с медицинским работником и предоставление обратной связи имеют решающее значение.

Иногда пациенты посещают врача раньше запланированного времени, часто из-за беспокойства или непонимания своих симптомов. ChatGPT может оказать некоторую помощь в решении проблем, связанных с психическим здоровьем, предоставляя стратегии преодоления трудностей, методы самопомощи и общую информацию о проблемах психического здоровья, включая эмоциональную поддержку. Считается, что современные системы такой помощи эффективно передают знания пациентам и могут отвечать на конкретные вопросы. Однако всплыли заметные проблемы, а именно — зачастую система выдаёт неправильные ответы, в совокупности с отсутствием способности проявлять сострадание, эмпатию, неспособностью к утешению, которые пациенты обычно ищут у врача. К сожалению, эти недостатки, как ожидается, не будут устранены в ближайшем будущем.

Искусственный разум оказывает неоценимую поддержку медицинским работникам, помогая им быть в курсе исследовательских работ, клинических руководств, протоколов лечения и анализа данных пациентов для помощи в диагностике и планировании лечения. Кроме того, в сфере научных работ нейросети приобрели популярность как ценный инструмент для составления исследовательских работ. Но тут есть одно тупиковое обстоятельство — результаты, в основном, основываются на обобщении предыдущих работ или предоставлении информации, основанной исключительно на предыдущих знаниях — что значительно воздействует на эффект новизны. Такой подход хорош в практике повышения квалификации, быстрому доступу к информации, созданию сценариев случаев и созданию контента для облегчения обучения, но абсолютно вредит порой в научно-изыскательской деятельности.

Для смягчения возникновения искусственных галлюцинаций, для систем ИИ решающее значение имеет тщательное обучение и тестирование с использованием разнообразных наборов данных. Недавнее исследование показало, что ни одна большая языковая модель, даже специально адаптированная под нужды медицинской диагностики, пока не может последовательно ставить точные диагнозы, даже с новейшими алгоритмами. Она только может диагностировать пациентов на основе определённых учебников или клинических вопросов, подчёркивая контраст между условными экзаменационными результатами и работой с реальными пациентами, которые часто проявляют интроспекцию, эмоции и сложную медицинскую, социальную и психиатрическую предысторию. То есть, исследование показало склонность ИИ к генерации правдоподобной, но фактически неверной информации.

Таким образом, текущая доказательная база для использования искусственного интеллекта в здравоохранении демонстрирует иерархическую модель: его позиция наиболее сильна в структурированных задачах, таких, как начальное медицинское образование и документирование. Очень умеренные способности в поддержке клинических решений и постановке предварительных диагнозов, а также в применении для непосредственного ухода за пациентами. Эта модель предполагает необходимость поэтапного подхода к внедрению в медицину, отдавая приоритет приложениям с надёжными доказательствами при разработке фреймворков для оценки возникающих вариантов использования.